腾讯云Elasticsearch服务提供在用户VPC内通过私有网vip访问集群的方式,用户可以通过Elasticsearch REST client编写代码访问集群并将自己的数据导入到集群中,当然也可以通过官方提供的组件如logstash和beats接入自己的数据。下面以官方的logstash和beats为例,介绍不同类型的数据源接入ES的方式。

前期准备

因为访问ES集群需要在用户VPC内进行,因此用户需要创建一台和ES集群相同VPC下的CVM实例或者Docker集群。

1. 使用logstash接入ES集群

CVM中访问ES集群

-

安装部署logstash与java8

wget https://artifacts.elastic.co/downloads/logstash/logstash-5.6.4.tar.gz tar xvf logstash-5.6.4.tar.gz yum install java-1.8.0-openjdk java-1.8.0-openjdk-devel -y 根据数据源类型自定义配置文件*.conf, 配置文件内容可参考后面介绍的数据源配置文件说明

-

执行logstash:

nohup ./bin/logstash -f ~/*.conf 2>&1 >/dev/null &

Docker中访问ES集群

自建Docker集群

-

拉取logstash官方镜像:

docker pull docker.elastic.co/logstash/logstash:5.6.9 根据数据源类型自定义配置文件*.conf, 放置了/usr/share/logstash/pipeline/ 目录下,目录可自定义

-

运行logstash

docker run --rm -it -v ~/pipeline/:/usr/share/logstash/pipeline/ docker.elastic.co/logstash/logstash:5.6.9

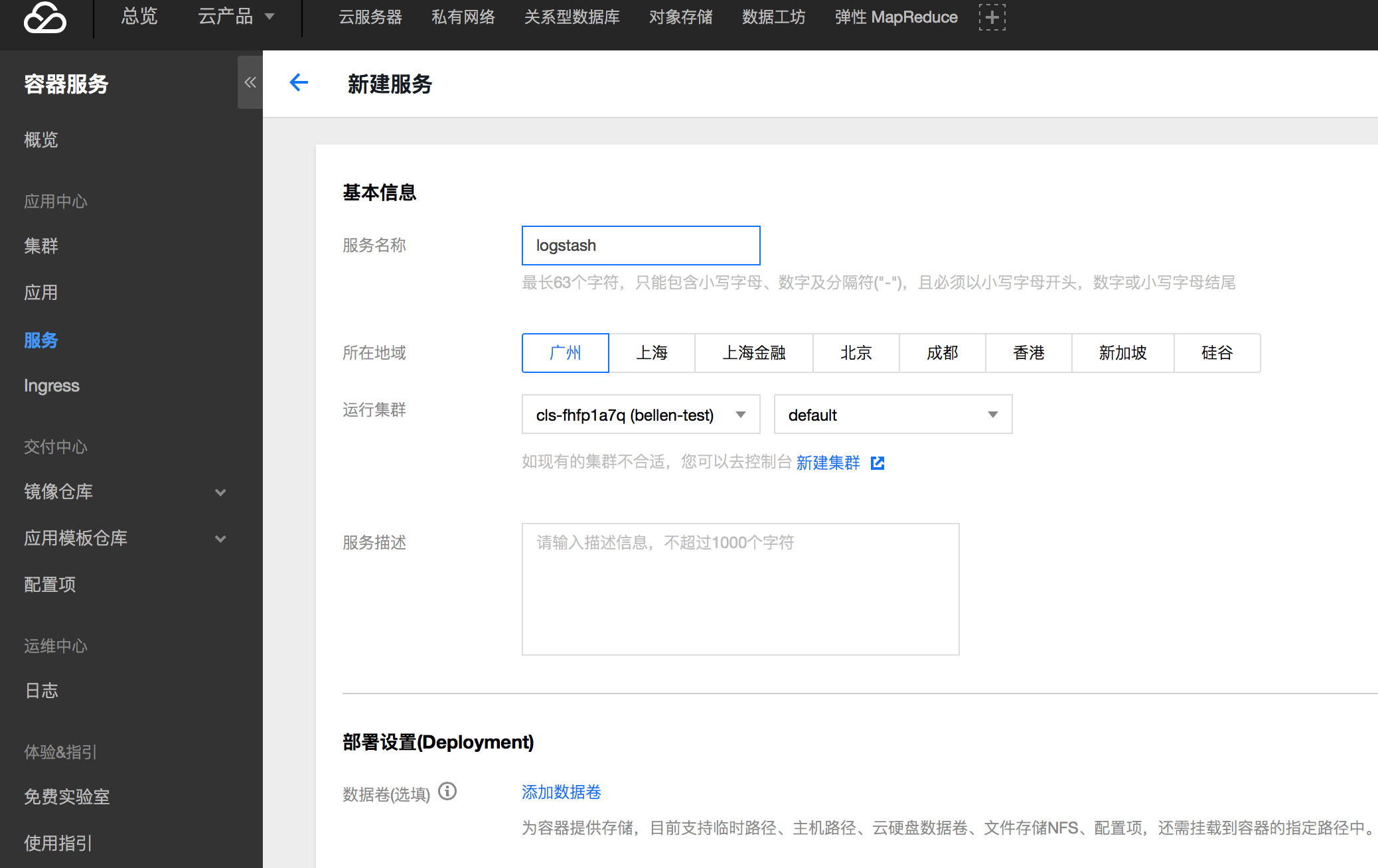

使用腾讯云容器服务

腾讯云的Docker集群运行于CVM实例上,所以需要先在容器服务的控制台上创建CVM集群。

步骤1:创建集群

步骤2:创建服务

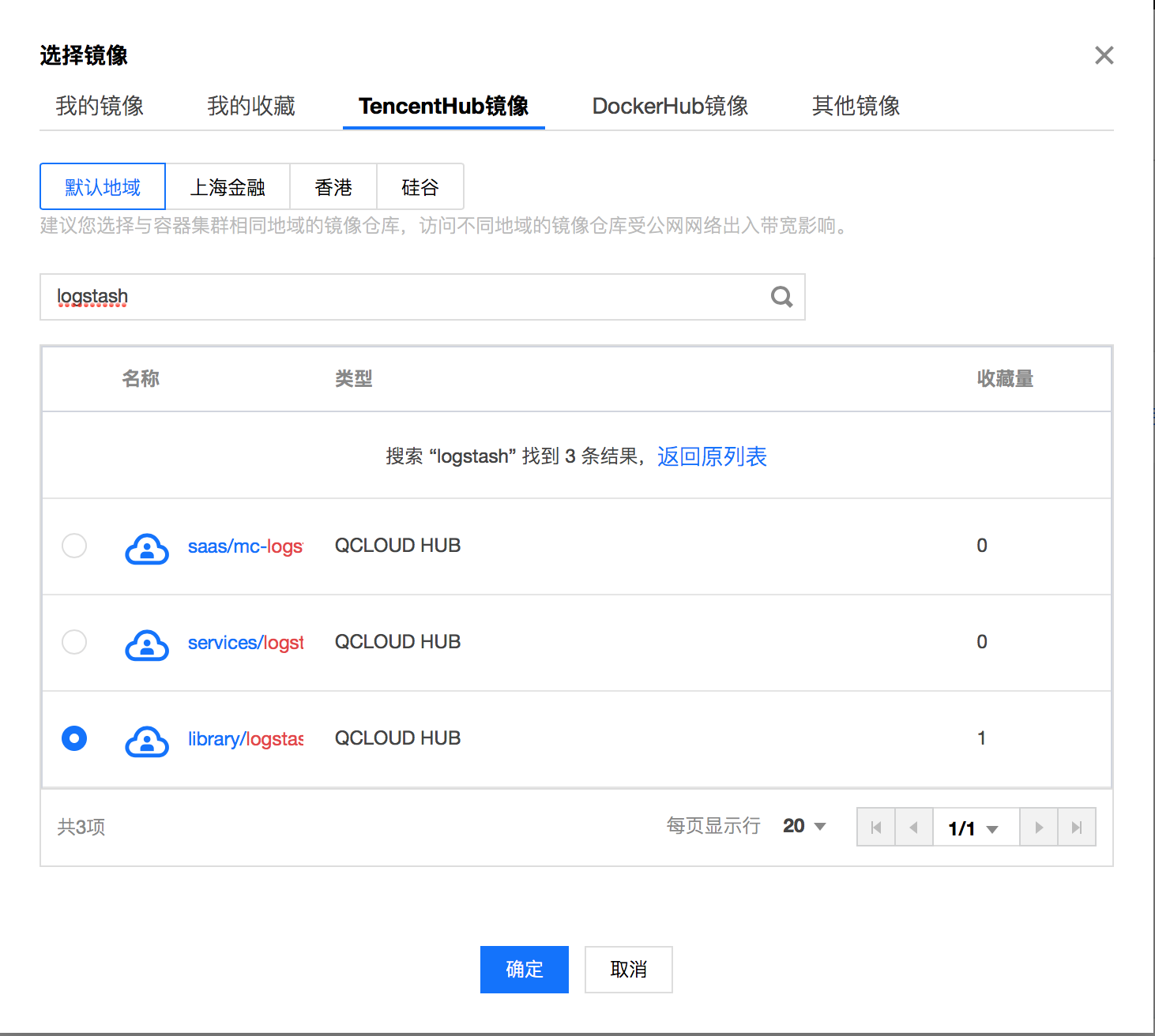

步骤3:选取logstash镜像

本例中使用TencentHub镜像仓库提供的logstash镜像,用户也可以自行创建logstash镜像

步骤4:创建数据卷

创建存放logstash配置文件的数据卷,本例中在CVM的/data/config目录下添加了名为logstash.conf配置文件,并将其挂在到Docker的/data目录下,从而使得容器启动时可以读取到logstash.conf文件

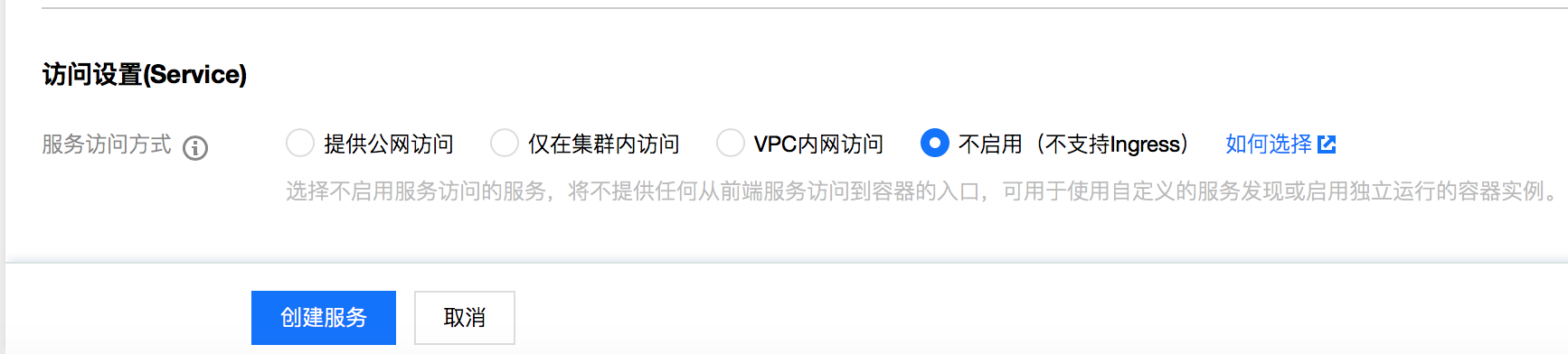

步骤5:配置运行参数

步骤6:根据需要配置服务参数并创建服务

配置文件说明

File数据源

input {

file {

path => "/var/log/nginx/access.log" # 文件路径

}

}

filter {

}

output {

elasticsearch {

hosts => ["http://172.16.0.89:9200"] # Elasticsearch集群的内网VIP地址和端口

index => "nginx_access-%{+YYYY.MM.dd}" # 自定义索引名称, 以日期为后缀,每天生成一个索引

}

}

更多有关File数据源的接入,请查阅官方文档:file input plugin

Kafka数据源

input{

kafka{

bootstrap_servers => ["172.16.16.22:9092"]

client_id => "test"

group_id => "test"

auto_offset_reset => "latest" #从最新的偏移量开始消费

consumer_threads => 5

decorate_events => true #此属性会将当前topic、offset、group、partition等信息也带到message中

topics => ["test1","test2"] #数组类型,可配置多个topic

type => "test" #数据源标记字段

}

}

output {

elasticsearch {

hosts => ["http://172.16.0.89:9200"] # Elasticsearch集群的内网VIP地址和端口

index => "test_kafka"

}

}

更多有关kafka数据源的接入,请查阅官方文档:kafka input plugin

JDBC连接的数据库数据源

input {

jdbc {

# mysql 数据库地址

jdbc_connection_string => "jdbc:mysql://172.16.32.14:3306/test"

# 用户名和密码

jdbc_user => "root"

jdbc_password => "Elastic123"

# 驱动jar包,如果自行安装部署logstash需要下载该jar,logstash默认不提供

jdbc_driver_library => "/usr/local/services/logstash-5.6.4/lib/mysql-connector-java-5.1.40.jar"

# 驱动类名

jdbc_driver_class => "com.mysql.jdbc.Driver"

jdbc_paging_enabled => "true"

jdbc_page_size => "50000"

# 执行的sql 文件路径+名称

#statement_filepath => "test.sql"

# 执行的sql语句

statement => "select * from test_es"

# 设置监听间隔 各字段含义(由左至右)分、时、天、月、年,全部为*默认含义为每分钟都更新

schedule => "* * * * *"

type => "jdbc"

}

}

output {

elasticsearch {

hosts => ["http://172.16.0.30:9200"]

index => "test_mysql"

document_id => "%{id}"

}

}

更多有关kafka数据源的接入,请查阅官方文档:jdbc input plugin

2. 使用Beats接入ES集群

Beats包含多种单一用途的的采集器,这些采集器比较轻量,可以部署并运行在服务器中收集日志、监控等数据,相对logstashBeats占用系统资源较少。

Beats包含用于收集文件类型数据的FileBeat, 收集监控指标数据的MetricBeat, 收集网络包数据的PacketBeat等,用户也可以基于官方的libbeat库根据自己的需求开发自己的Beat组件。

CVM中访问ES集群

-

安装部署filebeat

wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-5.6.4-linux-x86_64.tar.gz tar xvf logstash-5.6.4.tar.gz 配置filebeat.yml

-

执行filebeat:

nohup ./filebeat 2>&1 >/dev/null &

Docker中访问ES集群

自建Docker集群

-

拉取filebeat官方镜像:

docker pull docker.elastic.co/beats/filebeat:5.6.9 根据数据源类型自定义配置文件*.conf, 放置了/usr/share/logstash/pipeline/ 目录下,目录可自定义

-

运行filebeat

docker run docker.elastic.co/beats/filebeat:5.6.9

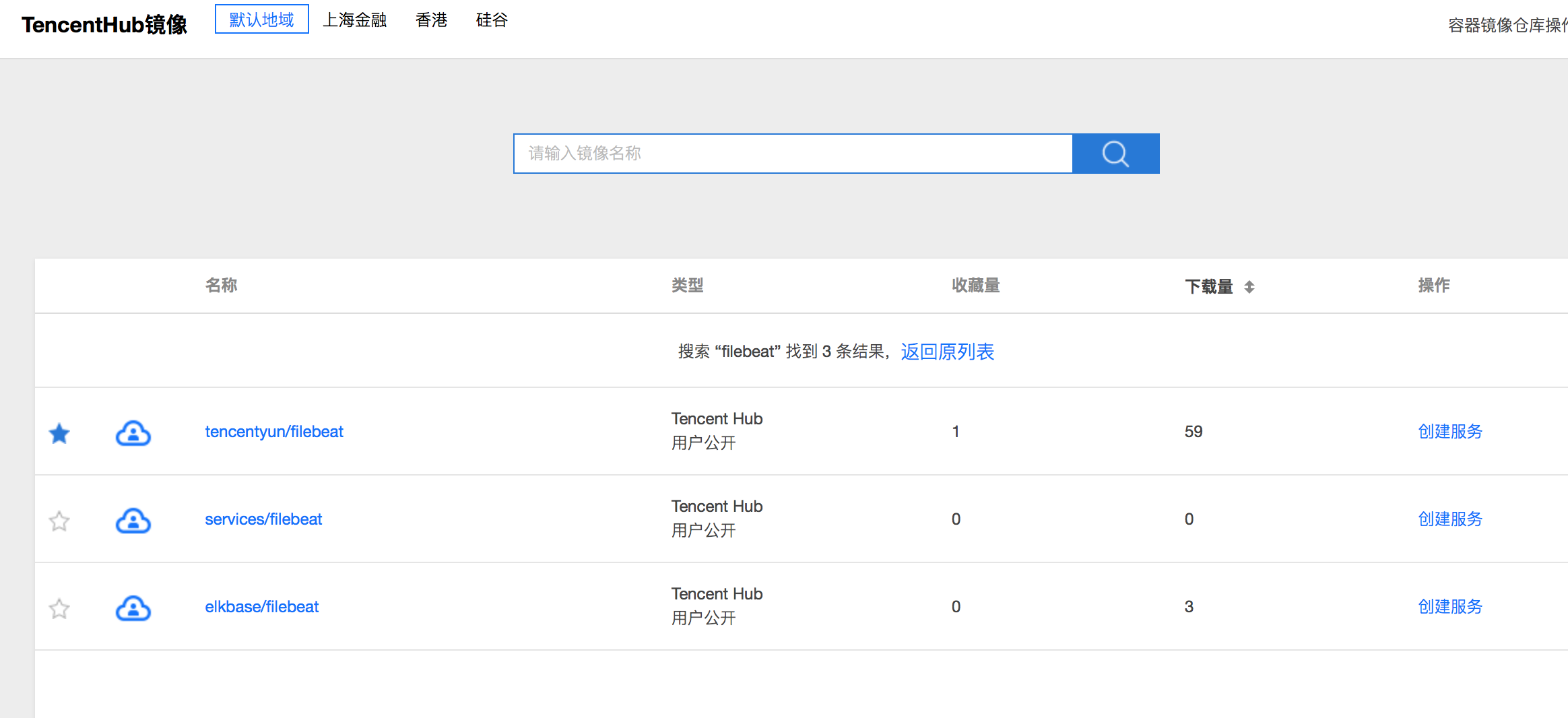

使用腾讯云容器服务

使用腾讯云容器服务部署filebeat的方式和部署logstash类似,镜像可以使用腾讯云官方提供的filebeat镜像

配置文件说明

配置filebeat.yml文件,内容如下:

// 输入源配置

filebeat.prospectors:

- input_type: log

paths:

- /usr/local/services/testlogs/*.log

// 输出到ES

output.elasticsearch:

# Array of hosts to connect to.

hosts: ["172.16.0.39:9200"]