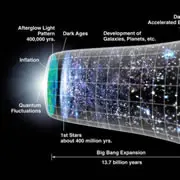

前几天细读GPT的paper,里面使用的基础模型和BERT一样都是Transformer,区别就在于GPT用的是单向Transformer,而BERT使用的是双向Transf...

-

2019-02-22 Transformer (GPT、BERT的核心)

2019-02-22 Transformer (GPT、BERT的核心) -

2019-02-19 GPT-2.0 Language Models are Unsupervised Multitask Learners

2019-02-19 GPT-2.0 Language Models are Unsupervised Multitask Learners这两天能一本正经胡说的语言模型GPT-2.0大火,官方OPENAI以模型太强大担心被坏人使用为由,也只公布了117M的模型,是不到号称的15亿参数的十分之一,同时牵起了OPE...

-

读点传统经典,学些做人道理。

-

-

-

Java程序员,专注Java编程技术,开发以后台为主前台为辅,曾经投身Hadoop大数据以及Ranger安全开发,活跃在大数据开源社区,同时推荐多种高效便捷的开发工具,分享自己的各种经验技巧总结。

-

爱是恒久忍耐,爱是永不止息。在地如同在天。

-

医生,临床营养师,专注营养十余年,主修疾病营养支持、体重管理和母婴营养。公众号:福爸聊营养

-

人生的路上,我们都在奔跑,我们总在赶超一些人,也总在被一些人超越。人生的要义,一是欣赏沿途的风景,二是抵达遥远的终点;人生的秘诀,寻找一种最适合自己的速度,莫因疾进而不堪重荷,莫因迟缓而空耗生命;人生的快乐,走自己的路,看自己的景。

-

500强跨国公司总经理——雀巢、荷兰皇家帝斯曼(前瑞士罗氏维生素)人类营养 前美国副总裁/大中华区总裁,丹麦科汉森 前大中华区总经理<br>世界级营养专家,中国益生菌引路人<br>管理学博士(EMBA, IMD,瑞士洛桑IMD校友董事)<br>作家——畅销书《自律》的作者、简书大V作家<br>电视节目特邀嘉宾——一站到底冠军,非你莫属Boss,职来职往首席面试官,时尚妈咪特邀世界级营养专家,喜马拉雅电台百万粉丝主播

-

以禅道参悟互联网、微信公众号:liukuang110

-

-

-

如果你是程序员,或者有一颗喜欢写程序的心,喜欢分享技术干货、项目经验、程序员日常囧事等等,欢迎投稿《程序员》专题。 专题主编:小彤花园 http://www.jianshu.com/users/4a4eb4feee62/ 【程序员】专题拒稿指北:http://www.jianshu.com/p/7c8b33b5f63b 投稿须知: 1.收录相关技术文章,但不限于技术,也可以是项目经验类的文章和程序员日常。 2.文章內不得有任何推广信息。包括但不限于公众号、微博、微信,更不得在通过投稿后再修改文章加入推广信息。你可以将这些推广以及个人信息放在个人主页介绍里。 3.字数极少,段落混乱,大段代码没有放到代码框的文章不收录 4.不相关的内容不收录,请确认文章内容和本专题相关 目前针对优质作者及爱好者,开设了官方程序员微信群,希望加入请发简信给主编小彤花园索取个人微信,主编会将你加入到【程序员】微信群,分享内容,收获知识。添加微信时备注昵称。

-